L’envoi de robots dans l’espace n’est pas qu’une mesure de sécurité, c’est avant tout une décision de gestion rigoureuse fondée sur une efficacité économique et technique écrasante.

- Une mission robotique est structurellement moins chère, car elle s’affranchit du coût colossal des systèmes de support-vie humains.

- L’autonomie est une nécessité absolue : les robots sont conçus pour exécuter des séquences complexes sans contact radio pendant des heures, voire des jours.

- La fiabilité à long terme, prouvée par des sondes actives depuis près de 50 ans, offre un retour sur investissement scientifique qu’aucune mission habitée lointaine ne pourrait égaler.

Recommandation : Analyser une mission spatiale sous l’angle de son efficacité économique et de sa résilience technique révèle la supériorité incontestable de l’approche robotique pour l’exploration scientifique des confins du système solaire.

Chaque euro investi dans l’exploration spatiale soulève une question légitime, particulièrement pour un décideur ou un contribuable : cette dépense est-elle justifiée ? L’imaginaire collectif, nourri de science-fiction, oppose souvent le courage de l’astronaute à la froideur du robot. La réponse la plus courante pour justifier les missions automatisées est simple : on envoie des machines parce que c’est trop dangereux pour les humains. Si cet argument est vrai, il est aussi profondément réducteur. Il masque la réalité d’une décision qui relève moins du compromis que d’une logique stratégique implacable.

La véritable question n’est pas « robot ou humain ? », mais plutôt « quel est l’outil le plus efficace pour atteindre un objectif scientifique précis dans un cadre de contraintes extrêmes ? ». En tant que gestionnaire de projet spatial, la réponse est dictée par des facteurs de coût, de risque, de fiabilité et de performance. Le choix du robot n’est pas un plan B, mais le résultat d’une analyse rationnelle qui démontre sa supériorité pour l’exploration des mondes lointains et hostiles. Les contraintes physiques, temporelles et budgétaires de l’espace lointain rendent l’option humaine non seulement plus risquée, mais économiquement et techniquement irréalisable pour la plupart des objectifs scientifiques.

Cet article propose de dépasser la vision romantique de l’exploration pour adopter le point de vue du chef de projet. Nous allons analyser, point par point, les raisons économiques, techniques et scientifiques qui font des missions robotiques un choix stratégique incontournable pour repousser les frontières de notre connaissance, là où chaque gramme, chaque watt et chaque bit de donnée compte.

Pour naviguer à travers cette analyse stratégique, voici les points clés que nous allons aborder. Chaque section décortique une contrainte majeure de l’exploration spatiale et démontre comment la solution robotique y répond avec une efficacité optimale.

Sommaire : Les raisons stratégiques derrière le choix des missions robotiques

- Pourquoi une mission robotique coûte 100 fois moins cher qu’une mission habitée ?

- Comment une sonde prend-elle des photos sans contact radio pendant 4 heures ?

- Stériliser les robots : pourquoi est-ce vital pour ne pas contaminer Mars ?

- L’erreur de conversion d’unités qui a crashé une sonde à 125 millions de dollars

- Quand la mission dépasse sa garantie : comment voyager 40 ans dans le vide ?

- Panneaux solaires ou RTG nucléaire : quel choix pour une mission au pôle sud lunaire ?

- Comment utiliser une planète comme fronde pour gagner de la vitesse sans carburant ?

- Sondes spatiales : comment communiquer des données HD depuis les confins du système solaire ?

Pourquoi une mission robotique coûte 100 fois moins cher qu’une mission habitée ?

L’argument économique est le pilier de la décision en faveur des missions robotiques. La différence de coût n’est pas marginale, elle est exponentielle. Le principal facteur n’est pas l’astronaute lui-même, mais tout ce qui est nécessaire pour le maintenir en vie. Un être humain requiert de l’oxygène, de l’eau, de la nourriture, une température contrôlée, une protection contre les radiations et un espace de vie. Chacun de ces éléments représente de la masse, et dans le domaine spatial, la masse est l’ennemi. Le coût pour envoyer un seul kilogramme en orbite terrestre basse est déjà exorbitant, estimé à environ 22 000 $ par kilogramme. Pour une mission vers Mars ou Jupiter, ce coût explose.

Un robot, en revanche, est un système optimisé pour une tâche. Il n’a pas besoin de respirer et peut fonctionner dans une plage de températures extrêmes. Sa masse est entièrement dédiée à sa mission : instruments scientifiques, système de communication, source d’énergie. En comparaison, un vaisseau habité doit consacrer une part écrasante de sa masse et de son volume au système de support-vie. Ce système doit être redondant et d’une fiabilité absolue, car toute défaillance est fatale.

Au-delà du coût de lancement, le coût opérationnel est un autre facteur déterminant. Maintenir un humain en vie dans l’espace a un prix quotidien. Sur la Station Spatiale Internationale (ISS), ce coût est un exemple frappant. Une mission robotique, une fois lancée, a des coûts de fonctionnement principalement liés au suivi depuis le sol par une équipe réduite. Le robot est un investissement initial qui produit de la science pendant des années, voire des décennies, sans les frais courants colossaux associés à la présence humaine.

En somme, le choix robotique est une décision de rationalité économique. Il permet de multiplier les missions, d’explorer davantage de cibles et de prendre des risques calculés avec des instruments plutôt qu’avec des vies humaines, maximisant ainsi le retour sur investissement scientifique pour chaque euro dépensé.

Comment une sonde prend-elle des photos sans contact radio pendant 4 heures ?

L’un des défis les plus contre-intuitifs de l’exploration du système solaire lointain est le délai de communication. L’image d’un opérateur pilotant un rover sur Mars avec un joystick en temps réel est une pure fiction. La lumière (et donc les ondes radio) met plusieurs minutes à voyager entre la Terre et Mars, et bien plus pour les planètes extérieures. Par exemple, il faut près de 22 heures et 30 minutes pour qu’un signal atteigne Voyager 1 et autant pour recevoir une réponse. Ce décalage rend tout contrôle direct impossible.

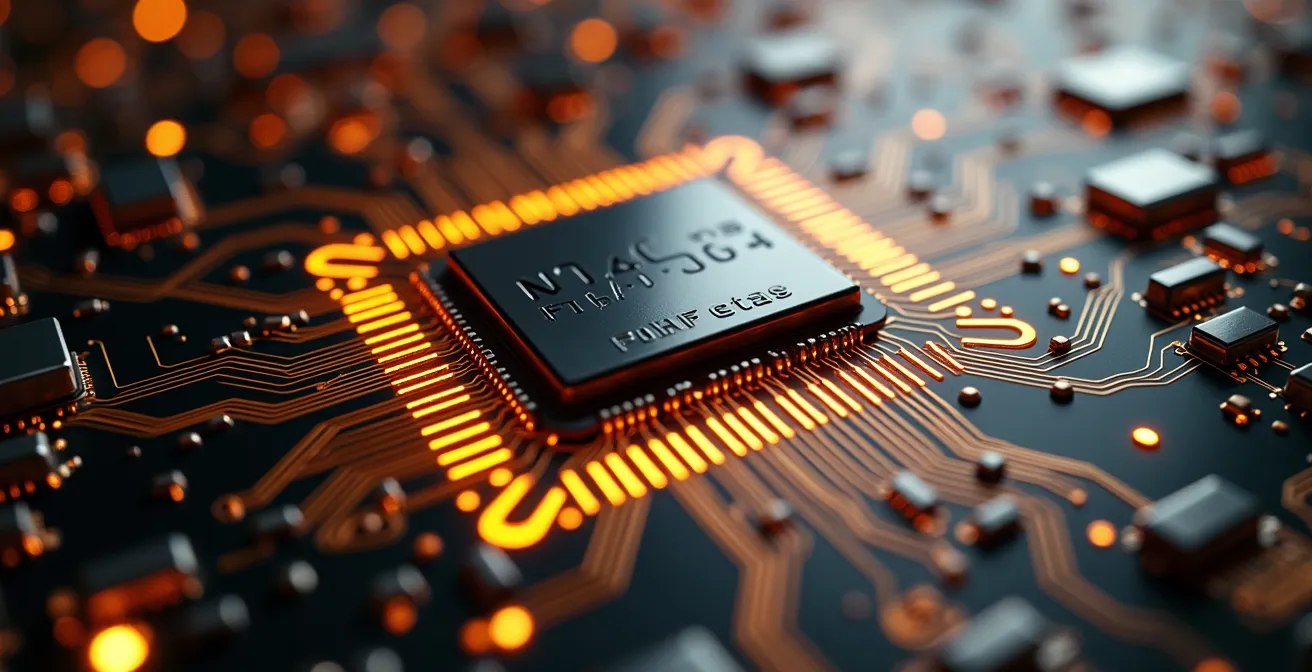

La solution réside dans l’autonomie décisionnelle du robot. Une sonde spatiale n’est pas une marionnette téléguidée, mais un ordinateur volant hautement sophistiqué. Les ingénieurs au sol ne lui envoient pas des commandes simples comme « avance » ou « prends une photo », mais des séquences complexes d’instructions qui seront exécutées des heures ou des jours plus tard. Une commande pour un survol planétaire peut contenir des milliers d’opérations : allumer tel instrument à telle heure, pivoter la sonde selon tel angle, commencer la prise d’images, compresser les données, puis les stocker en attendant la prochaine fenêtre de communication.

Cette complexité logicielle est le véritable cerveau de la mission. Pour bien le comprendre, il est utile de visualiser ses composants principaux. L’illustration ci-dessous décompose ce processus.

Comme le montre ce schéma, chaque étape joue un rôle crucial. Les processeurs embarqués, souvent durcis pour résister aux radiations, exécutent ces scripts à la lettre. La sonde dispose également de systèmes de sécurité autonomes. Si un capteur détecte une anomalie (une température trop élevée, une orientation incorrecte par rapport au Soleil), elle peut se mettre en « mode sans échec » toute seule, pointer son antenne vers la Terre et attendre les instructions des ingénieurs. Cette intelligence embarquée est ce qui permet à une mission de fonctionner pendant des heures en silence radio, comme lors d’un passage derrière une planète, en continuant d’accomplir sa mission scientifique avec précision.

Stériliser les robots : pourquoi est-ce vital pour ne pas contaminer Mars ?

L’un des objectifs ultimes de l’exploration de planètes comme Mars est de répondre à la question : la vie a-t-elle existé, ou existe-t-elle, ailleurs que sur Terre ? Pour avoir une chance de répondre à cette question, il est impératif de ne pas apporter la réponse avec nous. Ce principe, appelé protection planétaire, est un enjeu scientifique majeur et une autre raison fondamentale qui favorise les missions robotiques.

La Terre regorge de vie microbienne. Bactéries, archées et autres micro-organismes sont partout, y compris sur et dans notre corps. Envoyer des humains sur Mars, c’est envoyer avec eux un écosystème microbien complet, impossible à éradiquer totalement. Si de futures analyses du sol martien détectaient des microbes, comment savoir s’ils sont d’origine martienne ou s’il s’agit d’une contamination terrestre ? Ce serait un « faux positif » qui pourrait anéantir des décennies de recherche et nous laisser à jamais dans le doute.

Un robot, à l’inverse, peut être soumis à des procédures de stérilisation d’une rigueur extrême, définies par des traités internationaux comme le Traité de l’espace. Avant leur lancement, les sondes destinées à se poser sur des corps potentiellement habitables sont assemblées dans des salles blanches ultra-propres. Les composants sont ensuite « cuits » à haute température (plus de 110°C pendant des dizaines d’heures) pour tuer tout micro-organisme. Cette procédure est incompatible avec la survie humaine, mais parfaitement adaptée à des circuits électroniques et des structures métalliques.

Cette précaution est essentielle pour préserver l’intégrité scientifique de la mission. Elle garantit que si un jour un rover comme Perseverance ou Curiosity détecte une molécule organique complexe ou, qui sait, une trace de vie fossile, nous pourrons avoir la certitude qu’elle est bien martienne. Le robot n’est donc pas seulement un explorateur, il est aussi un instrument chirurgicalement propre, garant de la pureté des découvertes qu’il pourrait faire.

L’erreur de conversion d’unités qui a crashé une sonde à 125 millions de dollars

Si les robots sont des outils extraordinairement performants, leur succès dépend entièrement de la rigueur humaine. L’histoire de la mission Mars Climate Orbiter (MCO) en 1999 est une leçon brutale et coûteuse sur l’importance du moindre détail dans un projet spatial. La perte de cette sonde illustre parfaitement comment une simple erreur humaine peut avoir des conséquences catastrophiques, un risque qui serait inacceptable avec un équipage humain à bord.

La mission, d’un coût total qui s’élève, selon le rapport final de la NASA, à 327,6 millions de dollars, avait pour but d’étudier le climat martien. Cependant, à son arrivée près de la planète rouge, la sonde a disparu. L’enquête a révélé une cause à la fois simple et absurde : une erreur de conversion d’unités entre deux équipes d’ingénieurs.

L’erreur fatale de Mars Climate Orbiter

Le problème provenait des corrections de trajectoire. Le logiciel au sol, développé par Lockheed Martin, calculait la poussée des petits moteurs en livres-force, une unité du système impérial anglo-saxon. De son côté, l’équipe du Jet Propulsion Laboratory (JPL) de la NASA, qui opérait la sonde, s’attendait à recevoir ces données en newtons, l’unité du système métrique international. Comme une livre-force équivaut à environ 4,45 newtons, chaque correction de trajectoire était environ quatre fois et demie plus faible que prévu. Jour après jour, la sonde a dévié de sa trajectoire nominale, s’approchant dangereusement de la planète sans que personne ne s’en aperçoive.

Au lieu de se mettre en orbite à une altitude de sécurité de 150 kilomètres, la sonde est entrée dans l’atmosphère martienne à seulement 57 kilomètres. À cette altitude, les forces de frottement et la chaleur ont provoqué sa désintégration immédiate. Ce schéma illustre la différence tragique entre la trajectoire prévue et la trajectoire réelle.

Cet échec a conduit la NASA à revoir en profondeur ses processus de vérification et de validation. Il souligne un point clé : la complexité d’une mission spatiale crée d’innombrables points de défaillance potentiels, souvent situés à l’interface entre différentes équipes, logiciels ou systèmes. La gestion de ce risque est au cœur du métier.

Votre checklist pour valider un concept de mission

- Points de contact : Lister tous les canaux d’échange de données entre les équipes (logiciels, documents, réunions).

- Collecte : Inventorier toutes les unités de mesure utilisées (mètres, pieds, newtons, livres) et les standards de données.

- Cohérence : Confronter les formats de données attendus et fournis à chaque interface pour détecter les incohérences.

- Mémorabilité/émotion : Organiser des simulations « de bout en bout » où une donnée traverse tout le système pour vérifier son intégrité.

- Plan d’intégration : Établir un plan de double vérification systématique pour toutes les valeurs critiques transmises entre les équipes.

Quand la mission dépasse sa garantie : comment voyager 40 ans dans le vide ?

L’un des arguments les plus puissants en faveur de l’exploration robotique est son incroyable retour sur investissement à long terme. Conçues pour durer quelques années, de nombreuses sondes ont dépassé toutes les attentes, continuant à fournir des données précieuses des décennies après la fin de leur « garantie ». Le cas le plus emblématique est celui des sondes Voyager, et en particulier Voyager 1.

Lancée en 1977, sa mission principale était de survoler Jupiter et Saturne, ce qu’elle a accompli avec brio en 1980. La mission aurait pu s’arrêter là. Pourtant, après plus de 46 ans de service continu, elle continue son voyage dans l’espace interstellaire, devenant l’objet humain le plus lointain. Cette longévité n’est pas un hasard, elle est le fruit d’une conception exceptionnellement robuste et de l’ingéniosité des équipes au sol.

Les systèmes des sondes Voyager sont largement redondants. Si un composant tombe en panne, il existe souvent un système de secours pour prendre le relais. L’électronique, bien que primitive selon les standards actuels (la mémoire totale de l’ordinateur de bord est des milliers de fois plus faible que celle d’un smartphone moderne), est extrêmement résistante aux radiations. Cette conception défensive est la clé de sa durabilité. Voyager n’est pas seulement un succès scientifique, c’est un triomphe de l’ingénierie de la fiabilité.

Réparation logicielle de Voyager 1 à 24 milliards de kilomètres

Fin 2023, Voyager 1 a commencé à envoyer des données incohérentes, un signe de défaillance matérielle. Après des mois d’analyse, les ingénieurs ont identifié une puce mémoire défectueuse dans le système de données de vol (FDS). Remplacer la puce étant impossible, ils ont conçu un correctif logiciel audacieux. Le code qui se trouvait sur la puce défectueuse a été méticuleusement découpé en plusieurs fragments, qui ont ensuite été stockés dans différentes zones de la mémoire restante du FDS. L’envoi de cette mise à jour a pris près d’une journée, et après plusieurs semaines, la sonde a recommencé à transmettre des données scientifiques cohérentes. Cette « transplantation » de code à distance est un exploit technique qui démontre la résilience et l’adaptabilité d’une mission bien conçue.

Une mission habitée de 40 ans est impensable, tant pour des raisons biologiques que psychologiques. Un robot, lui, est un actif scientifique qui continue de produire de la valeur bien au-delà de son coût initial, amortissant l’investissement sur des décennies.

Panneaux solaires ou RTG nucléaire : quel choix pour une mission au pôle sud lunaire ?

L’énergie est le nerf de la guerre pour toute mission spatiale. Sans une alimentation électrique fiable et continue, même le robot le plus sophistiqué n’est qu’un morceau de métal inerte. Le choix de la source d’énergie est une décision stratégique qui dépend entièrement de l’environnement de la mission. Un cas d’étude parfait est la planification d’une mission au pôle sud de la Lune, une région d’un immense intérêt scientifique car ses cratères, perpétuellement à l’ombre, pourraient abriter de la glace d’eau.

Cette obscurité permanente est à la fois une promesse et un défi. L’absence de Soleil rend les panneaux solaires, la source d’énergie la plus courante, inopérants dans ces zones. De plus, même en dehors des cratères, la Lune connaît des nuits qui durent près de 14 jours terrestres consécutifs. Survivre à une nuit lunaire glaciale et sans soleil est un obstacle majeur pour un rover alimenté par des panneaux solaires, qui doit compter sur des batteries lourdes et volumineuses.

Face à ce dilemme, une autre option s’impose : le générateur thermoélectrique à radioisotope (RTG). Cette technologie n’est pas un réacteur nucléaire, mais une sorte de pile nucléaire. Elle utilise la chaleur dégagée par la désintégration naturelle d’un élément radioactif, comme le plutonium-238, pour produire de l’électricité via un thermocouple. Son principal avantage est de fournir une puissance constante et prévisible pendant des décennies, indépendamment de l’ensoleillement, de la température ou de l’heure. Le tableau suivant résume le dilemme pour un chef de projet.

| Critère | Panneaux solaires | RTG nucléaire |

|---|---|---|

| Continuité énergétique | Interrompue la nuit | 24h/24, 7j/7 |

| Poids système | Léger + batteries lourdes | Compact mais lourd |

| Zones d’ombre | Inopérant | Fonctionne partout |

| Durée de vie | Dégradation progressive | Décroissance prévisible |

Pour une mission d’exploration des cratères du pôle sud lunaire, le choix du RTG est donc une évidence technique. Il garantit la survie du robot pendant les longues nuits et lui permet d’opérer dans les zones d’ombre les plus intéressantes scientifiquement. C’est une décision de gestion du risque et de la continuité opérationnelle, assurant que la mission pourra atteindre ses objectifs les plus ambitieux.

Comment utiliser une planète comme fronde pour gagner de la vitesse sans carburant ?

Atteindre les confins du système solaire demande des vitesses prodigieuses, bien au-delà de ce que les fusées les plus puissantes peuvent fournir seules. Emporter suffisamment de carburant pour un tel voyage rendrait la sonde si lourde qu’elle ne pourrait même pas quitter l’orbite terrestre. La solution à ce paradoxe est l’une des manœuvres les plus élégantes et les plus efficaces de l’arsenal spatial : l’assistance gravitationnelle.

Le principe consiste à utiliser le champ de gravité d’une planète comme une fronde. En s’approchant d’une planète massive comme Jupiter, la sonde est « attrapée » par sa gravité et accélérée. Si la trajectoire est calculée avec une précision extrême, la sonde peut « voler » un peu de l’énergie orbitale de la planète, gagnant ainsi une vitesse considérable par rapport au Soleil, sans dépenser une seule goutte de carburant. C’est une optimisation de trajectoire qui s’apparente à un « déjeuner gratuit » cosmique.

Le programme Voyager est l’exemple le plus spectaculaire de cette technique. Il a été rendu possible par un alignement rare des planètes extérieures (Jupiter, Saturne, Uranus et Neptune), qui n’arrive, selon les calculs, qu’une fois tous les 175 ans. Cette opportunité unique a permis à la mission Voyager 2 de réaliser son « Grand Tour ».

Le Grand Tour de Voyager 2

Voyager 2 a utilisé l’assistance gravitationnelle pour visiter successivement Jupiter en 1979, ce qui lui a donné l’élan nécessaire pour atteindre Saturne en 1981. Le survol de Saturne l’a ensuite projetée vers Uranus (1986), et celui d’Uranus l’a finalement envoyée vers Neptune (1989). Sans cette série de « coups de fouet » gravitationnels, un tel voyage aurait pris des décennies de plus, voire aurait été tout simplement impossible avec la technologie de l’époque. Cette stratégie a transformé une mission vers une seule planète en une odyssée explorant quatre mondes géants pour le prix d’un.

La maîtrise de l’assistance gravitationnelle est un exemple parfait de l’optimisation des ressources qui caractérise l’exploration robotique. Au lieu de lutter contre la gravité, les ingénieurs l’utilisent comme un moteur. C’est le summum de l’efficacité, permettant des missions ambitieuses qui seraient autrement hors de portée, tant sur le plan technique que budgétaire.

À retenir

- Le coût d’une mission habitée n’est pas le lancement, mais le support-vie continu (oxygène, eau, nourriture), ce qui rend les missions robotiques des centaines de fois plus efficientes économiquement.

- L’autonomie n’est pas une option mais une nécessité absolue : les robots sont conçus pour exécuter des séquences complexes sans contact radio pendant des heures, voire des jours, en raison de la latence des communications.

- La fiabilité à très long terme des sondes robotiques, certaines étant actives depuis près de 50 ans, offre un retour sur investissement scientifique inégalé, transformant un coût initial en un flux continu de découvertes.

Sondes spatiales : comment communiquer des données HD depuis les confins du système solaire ?

Envoyer une sonde à des milliards de kilomètres est une chose. En recevoir des données en est une autre, et c’est peut-être le défi technique le plus vertigineux. La sonde Voyager 1 communique aujourd’hui avec la Terre depuis une distance de plus de 24 milliards de kilomètres. À cette distance, la puissance de son émetteur (environ 20 watts, soit celle d’une ampoule de réfrigérateur) est si diluée qu’elle devient incroyablement faible à son arrivée sur Terre. Pour saisir l’ampleur du défi, le Deep Space Network (DSN) de la NASA utilise une analogie frappante :

La puissance du signal de Voyager 1 reçu sur Terre est des milliards de fois plus faible que la puissance d’une pile de montre.

– Deep Space Network, Documentation technique NASA DSN

La détection d’un signal aussi infinitésimal est un exploit rendu possible par le Deep Space Network (DSN), un réseau de trois complexes de communication géants répartis stratégiquement sur le globe (Californie, Espagne, Australie). Cette répartition assure qu’à tout moment, au moins une station peut « voir » une sonde donnée, compensant la rotation de la Terre. Chaque complexe est équipé d’antennes paraboliques gigantesques, dont la plus grande mesure 70 mètres de diamètre.

Les oreilles géantes du Deep Space Network

Ces antennes agissent comme des « collecteurs de photons » radio. Leur immense surface leur permet de capter les signaux les plus faibles en provenance de l’espace lointain. Le signal reçu est ensuite traité par des récepteurs cryogéniques, refroidis à des températures proches du zéro absolu pour minimiser le bruit électronique et isoler le précieux signal de la sonde. Des techniques de codage avancées, comme le codage de Reed-Solomon, permettent de corriger les erreurs qui peuvent survenir pendant la transmission. C’est grâce à cette infrastructure monumentale et à des décennies de perfectionnement que nous pouvons aujourd’hui recevoir des images et des données scientifiques des confins de notre système solaire.

La communication à longue distance est donc un système en deux parties : un émetteur efficace et peu gourmand en énergie côté sonde, et une infrastructure de réception extraordinairement sensible et puissante sur Terre. C’est la synergie entre ces deux éléments qui permet de transformer un murmure cosmique en découvertes scientifiques majeures.

Pour évaluer la pertinence de tout projet d’exploration, l’analyse ne doit donc pas opposer l’homme au robot, mais évaluer chaque option selon sa capacité à atteindre des objectifs scientifiques précis dans un cadre budgétaire et technique maîtrisé. L’exploration robotique, par sa rigueur, son efficacité et sa résilience, représente le choix de la raison pour sonder l’inconnu.