La véritable optimisation des coûts en chimie ne consiste pas à couper les budgets, mais à repenser l’échelle et l’intelligence des procédés pour gagner en efficacité.

- L’intensification des procédés (production modulaire, micro-réacteurs) surpasse souvent les systèmes traditionnels en coût total de possession (TCO).

- La simulation prédictive (CFD, jumeaux numériques) prévient les défaillances coûteuses et dangereuses avant qu’elles ne surviennent.

Recommandation : Auditez vos procédés non pas sous l’angle du volume, mais de l’efficacité du transfert de matière et de chaleur pour identifier les gisements de rentabilité cachés.

Face à la pression constante sur les marges et à l’impératif absolu de sécurité, les responsables de production dans l’industrie chimique se trouvent souvent face à un dilemme. La vision classique oppose rentabilité et sécurité, suggérant que l’un se fait forcément au détriment de l’autre. Les approches habituelles se concentrent sur des leviers connus : négociation des matières premières, automatisation à grande échelle ou, pire, des coupes dans les budgets de maintenance qui fragilisent l’outil de production. Ces stratégies atteignent aujourd’hui leurs limites et peuvent même s’avérer contre-productives.

Et si la véritable clé pour débloquer une réduction de coûts substantielle et durable ne résidait pas dans des économies de bouts de chandelle, mais dans une approche radicalement différente ? L’angle que nous allons explorer est contre-intuitif : penser plus petit, plus agile et plus précisément pour gagner plus gros. Il s’agit de l’intensification des procédés. Ce principe consiste à utiliser des équipements plus compacts, plus efficaces et mieux contrôlés pour obtenir des rendements supérieurs avec une empreinte opérationnelle réduite. Cette stratégie transforme la sécurité, non plus en un centre de coût, mais en un résultat direct d’un processus maîtrisé.

Cet article n’est pas une liste de conseils génériques. C’est une feuille de route pour consultants, pensée pour les ingénieurs et responsables de production qui cherchent un retour sur investissement (ROI) tangible. Nous allons déconstruire cette approche en analysant le choix technologique, en identifiant les erreurs critiques à éviter, en démontrant comment la modélisation devient un allié de la rentabilité, et enfin, en voyant comment transformer la R&D d’un centre de coût en un véritable centre de profit pour l’entreprise.

Pour naviguer efficacement à travers ces stratégies d’optimisation, ce guide est structuré autour de points d’action et d’analyses concrets. Le sommaire ci-dessous vous permettra d’accéder directement aux leviers qui vous concernent le plus.

Sommaire : Stratégies pour une production chimique rentable et sûre

- Batch ou flux continu : quel procédé choisir pour des volumes intermédiaires ?

- L’erreur de refroidissement qui peut transformer votre réacteur en bombe à retardement

- Pourquoi réduire la taille de vos équipements peut augmenter votre rendement ?

- Quand la simulation CFD devient-elle indispensable pour éviter les zones mortes dans les cuves ?

- Comment récupérer la chaleur fatale pour chauffer vos pré-traitements gratuitement ?

- Pourquoi faire confiance à un modèle mathématique pour la sécurité d’un avion ?

- Le piège de la « vallée de la mort » entre le bécher et le pilote industriel

- Comment transformer un laboratoire R&D en centre de profit pour l’entreprise ?

Batch ou flux continu : quel procédé choisir pour des volumes intermédiaires ?

Le choix entre un procédé batch (par lots) et un procédé en flux continu est un arbitrage fondamental qui conditionne toute l’économie d’une ligne de production. Le batch offre une flexibilité inégalée, idéale pour les petites séries et les produits multiples. Le flux continu, lui, excelle dans la production de masse à bas coût, mais souffre d’une rigidité et d’un coût d’entrée (CAPEX) élevés. Pour les volumes intermédiaires, où se situe une grande partie de la chimie fine, aucune de ces deux options n’est parfaite. L’analyse doit donc dépasser le simple coût d’achat pour intégrer le coût total de possession (TCO). En effet, des analyses industrielles montrent que le prix d’achat initial ne représente que 20 à 30% du coût total sur la durée de vie de l’équipement.

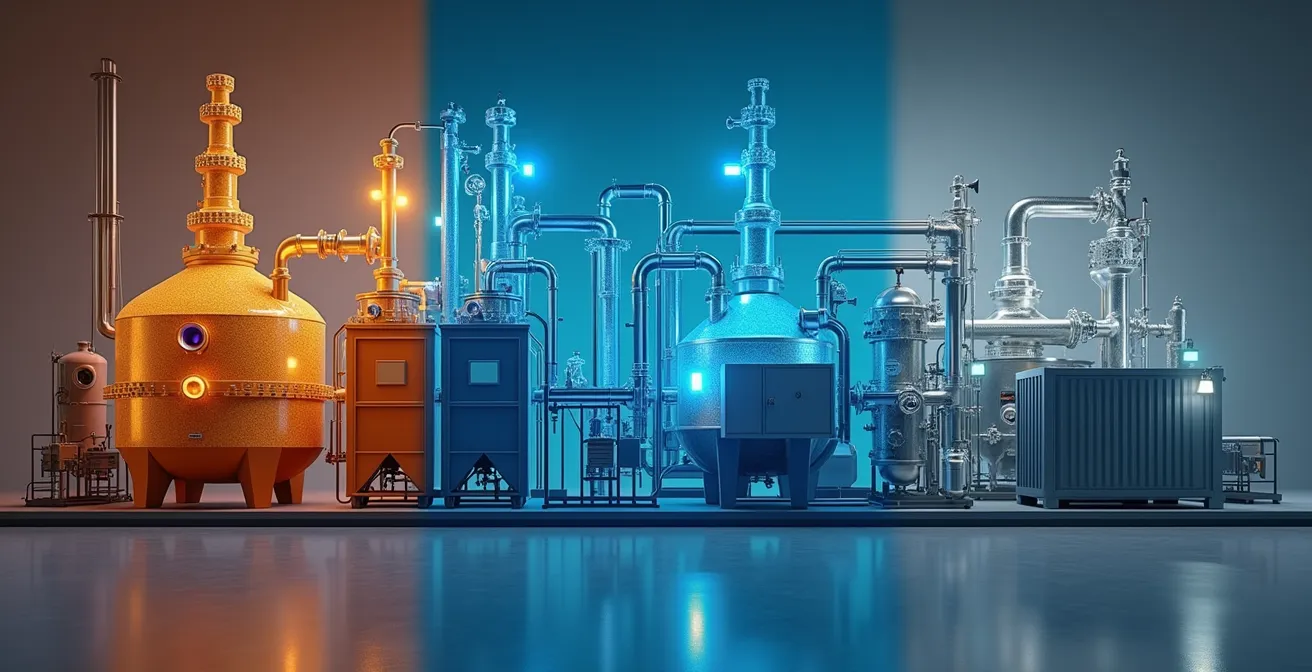

L’angle stratégique pour les volumes intermédiaires est l’émergence d’une troisième voie : la production modulaire ou « skid-mounted ». Cette approche combine les avantages des deux mondes. Les unités sont pré-assemblées, testées en usine et livrées prêtes à connecter, ce qui réduit considérablement le temps d’installation et les risques sur site. Elle offre une meilleure flexibilité que le continu traditionnel tout en optimisant les coûts opérationnels (OPEX) par rapport au batch, notamment grâce à un meilleur contrôle et une automatisation ciblée.

L’illustration ci-dessus met en lumière les différences fondamentales de configuration. Le réacteur batch est un grand volume unique, le flux continu est un réseau de tuyauterie complexe, tandis que l’unité modulaire est un ensemble compact et intégré. Cette compacité est un atout majeur pour l’optimisation de l’espace au sol et la simplification de la maintenance.

Le tableau suivant synthétise l’analyse TCO de ces trois technologies, mettant en évidence pourquoi l’approche modulaire représente souvent le meilleur ROI pour les productions intermédiaires.

| Critère TCO | Procédé Batch | Procédé Continu | Production Modulaire |

|---|---|---|---|

| Coût initial (CAPEX) | Modéré | Élevé | Intermédiaire |

| Coûts opérationnels (OPEX) | Variables élevés | Fixes optimisés | Flexibles |

| Flexibilité produits | Excellente | Limité | Bonne |

| Temps de changement | 2-8 heures | 24-48 heures | 1-4 heures |

| ROI typique | 2-3 ans | 3-5 ans | 1.5-2.5 ans |

L’erreur de refroidissement qui peut transformer votre réacteur en bombe à retardement

Dans les réactions exothermiques, la maîtrise du refroidissement n’est pas une simple question d’efficacité, c’est une condition sine qua non de la sécurité. Une défaillance ou une sous-estimation de la capacité de refroidissement peut entraîner un emballement thermique, une réaction en chaîne où l’augmentation de la température accélère la réaction, qui à son tour libère encore plus de chaleur. Le résultat peut être une surpression catastrophique et l’explosion du réacteur. L’erreur la plus courante n’est pas l’absence de système de refroidissement, mais sa mauvaise conception, souvent basée sur des hypothèses optimistes ou une méconnaissance des réactions secondaires potentielles à haute température.

Attendre un incident pour réagir est une approche inacceptable. L’optimisation des coûts passe ici par la prévention, et la technologie moderne offre des outils puissants pour cela. L’industrie pharmaceutique, par exemple, a largement adopté la modélisation prédictive pour sécuriser ses procédés. Comme le souligne une analyse sur le sujet, ces outils permettent d’identifier les zones de danger et les limites de l’enveloppe de fonctionnement sécuritaire (Safe Operating Envelope) sans jamais avoir à réaliser une expérience physique risquée. C’est une démarche qui génère des gains directs en coûts, en temps et en productivité tout en renforçant drastiquement la sécurité.

Ces modèles ne se contentent pas de simuler le nominal ; leur vraie valeur est de tester les scénarios du pire : panne d’agitateur, erreur de dosage, défaillance du groupe froid. En comprenant comment le système réagit dans ces conditions extrêmes, on peut concevoir des systèmes de sécurité (disques de rupture, évents d’urgence) correctement dimensionnés et des procédures opératoires robustes qui empêchent d’atteindre le point de non-retour. La sécurité devient alors une science prédictive, et non une réaction post-incident.

Plan d’action pour la sécurisation thermique de votre réacteur

- Cartographier toutes les réactions secondaires potentielles via calorimétrie différentielle à balayage (DSC).

- Installer des « soft sensors » corrélant pression, puissance d’agitation et température pour une détection fine.

- Implémenter un système de détection précoce des dérives thermiques basé sur la dérivée de la température.

- Concevoir le procédé en mode semi-batch (ajout contrôlé du réactif limitant) pour éviter l’accumulation réactive.

- Valider le système de sécurité par simulation CFD des scénarios d’emballement les plus critiques.

Pourquoi réduire la taille de vos équipements peut augmenter votre rendement ?

L’adage « bigger is better » a longtemps dominé la conception des usines chimiques. Pourtant, cette logique est de plus en plus remise en question par le concept d’intensification des procédés. L’idée est simple : en réduisant drastiquement la taille des réacteurs (jusqu’à des micro-réacteurs), on augmente de façon exponentielle le ratio surface/volume. Cette caractéristique géométrique améliore de plusieurs ordres de grandeur les transferts de chaleur et de matière. Une réaction qui prendrait des heures dans un réacteur de 10 m³ peut être réalisée en quelques secondes ou minutes dans un système continu miniaturisé, avec un contrôle de la température quasi-parfait, éliminant presque totalement le risque d’emballement thermique.

Cette approche a un impact direct et massif sur le rendement et les coûts. Un meilleur contrôle signifie moins de sous-produits indésirables, une pureté accrue du produit final et donc une simplification des étapes de purification, souvent très coûteuses. De plus, des équipements plus petits et modulaires signifient des coûts d’investissement (CAPEX) plus faibles, une construction plus rapide et une maintenance simplifiée. La maintenance prédictive, par exemple, devient beaucoup plus efficace sur des systèmes compacts et instrumentés. La maintenance prédictive permet, selon une analyse de McKinsey, de réduire les coûts de 25% et d’augmenter la disponibilité des équipements de 30%.

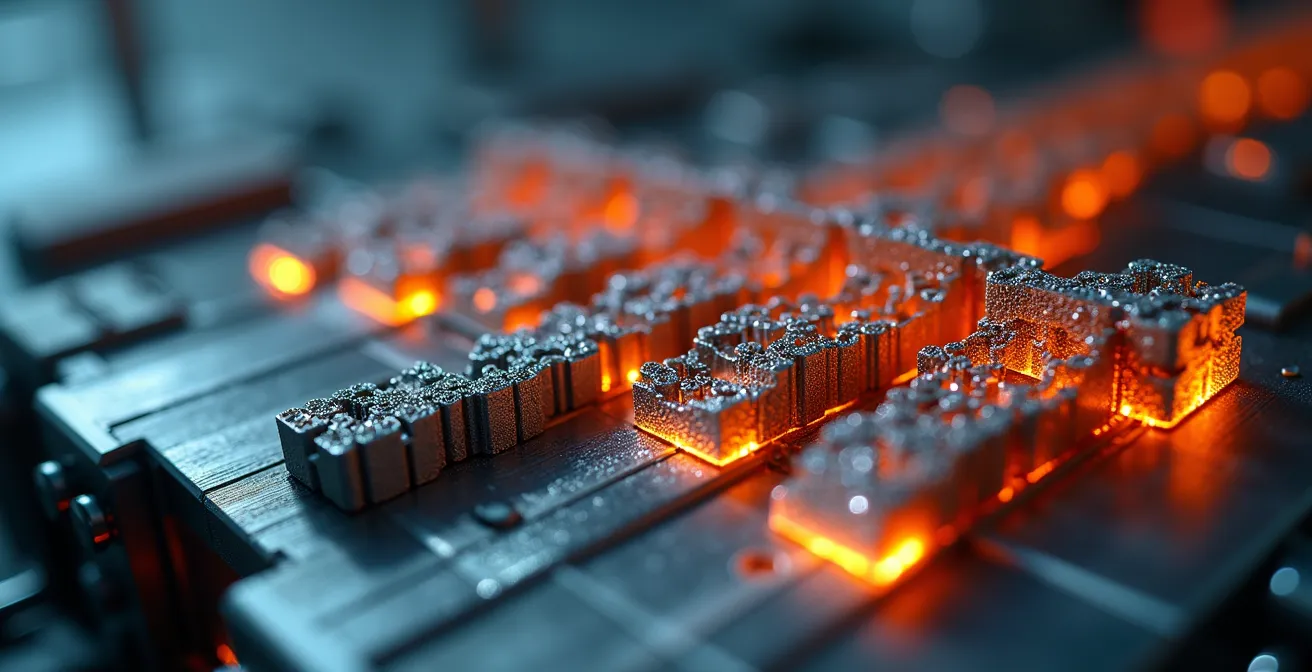

Ce gros plan sur un micro-réacteur illustre la complexité et la précision de ces nouveaux outils. Chaque canal est un réacteur individuel, permettant une production continue, hautement contrôlée et facilement modulable (scale-out) en ajoutant simplement des unités en parallèle. Loin d’être une curiosité de laboratoire, cette technologie est aujourd’hui une alternative mature et rentable pour de nombreuses synthèses chimiques.

En fin de compte, réduire la taille n’est pas un objectif en soi, mais le moyen d’atteindre un contrôle ultime sur la réaction. C’est ce contrôle qui génère le rendement, la qualité et la sécurité, trois piliers qui conduisent directement à une rentabilité accrue. L’investissement se déplace du tonnage d’acier vers l’intelligence du design et de l’instrumentation.

Quand la simulation CFD devient-elle indispensable pour éviter les zones mortes dans les cuves ?

Une cuve agitée n’est jamais parfaitement homogène. Inévitablement, des « zones mortes » se forment : des régions où le mélange est faible ou inexistant. Ces zones sont le cauchemar de l’ingénieur procédés. Elles peuvent causer des points chauds localisés, une dégradation du produit, une réaction incomplète ou la sédimentation de solides. Le résultat ? Des lots non conformes, un rendement plus faible et des coûts de retraitement ou de mise au rebut qui plombent la rentabilité. Tenter d’optimiser une agitation « à l’aveugle » en changeant la vitesse ou le type de mobile est une démarche empirique coûteuse et souvent inefficace.

La simulation numérique de la mécanique des fluides, ou CFD (Computational Fluid Dynamics), devient indispensable dès que l’homogénéité est un facteur critique de qualité ou de sécurité. La CFD permet de visualiser les lignes de courant, les vitesses de fluide et la distribution de la température ou de la concentration à l’intérieur de la cuve. Elle rend visible l’invisible. On peut ainsi tester virtuellement des dizaines de configurations d’agitation, de formes de cuve ou de points d’injection pour trouver le design optimal avant même de commander la moindre pièce d’équipement.

Le ROI de la CFD est direct. Une étude de cas dans un processus chimique continu a démontré qu’en utilisant la modélisation pour optimiser les flux et éliminer les zones mortes, l’entreprise a pu atteindre une réduction de 40% des lots non conformes. Ces lots, auparavant vendus avec une décote importante ou recyclés, sont désormais conformes aux spécifications du premier coup. L’investissement dans la simulation est ainsi rapidement amorti par l’amélioration de la qualité et la réduction des pertes.

La CFD n’est plus un outil réservé à l’aéronautique. Pour l’industrie chimique, c’est un levier d’optimisation puissant pour garantir que chaque molécule dans le réacteur subit le traitement souhaité. Elle devient indispensable non seulement pour la conception de nouveaux équipements, mais aussi pour le « troubleshooting » et l’optimisation des installations existantes, permettant d’identifier et de corriger des défauts de conception qui coûtent cher depuis des années.

Comment récupérer la chaleur fatale pour chauffer vos pré-traitements gratuitement ?

Dans un site chimique, l’énergie est l’un des postes de dépenses les plus importants. Chaque réaction qui dégage de la chaleur (exothermique) et chaque fluide chaud qui est refroidi représente une source d’énergie perdue, appelée chaleur fatale. Dissiper cette chaleur dans des tours de refroidissement a un double coût : le coût de l’électricité pour faire fonctionner les pompes et ventilateurs, et le coût d’opportunité de ne pas réutiliser cette énergie. L’une des optimisations les plus rentables consiste à « boucler la boucle thermique » : utiliser la chaleur d’un processus pour en préchauffer un autre.

Le gisement le plus courant et le plus simple à exploiter est la récupération de chaleur sur les réseaux de vapeur et de condensats. Souvent, des vapeurs « froides » (basse pression) ou des condensats chauds sont simplement purgés ou refroidis avant d’être renvoyés à la bâche alimentaire de la chaudière. C’est une perte énergétique pure. L’installation d’échangeurs de chaleur permet de récupérer ces calories pour préchauffer l’eau d’alimentation de la chaudière, des réactifs, ou même l’air des bâtiments.

Un cas concret d’optimisation sur un site industriel a montré qu’en implémentant un système de suivi intelligent et en optimisant le réseau de purgeurs, l’usine a réussi à augmenter de 30% la récupération des vapeurs « froides ». Cette optimisation a généré une double économie : une réduction directe de la consommation de gaz de la chaudière et une diminution de l’empreinte carbone. Le plus intéressant est que le retour sur investissement a été inférieur à deux ans, et même quasi-immédiat dans les zones où les capteurs de suivi étaient déjà présents. Cela démontre que des gains significatifs peuvent être obtenus avec des investissements mineurs.

L’audit énergétique d’un site doit donc systématiquement cartographier les sources de chaleur (réacteurs, condenseurs, compresseurs) et les besoins en chaleur (préchauffage de réactifs, étuves, chauffage de locaux). La mise en place d’un réseau d’échangeurs thermiques, ou « pincement », est une stratégie de base du génie des procédés qui offre un ROI rapide et une réduction durable des coûts opérationnels.

Pourquoi faire confiance à un modèle mathématique pour la sécurité d’un avion ?

Cette question, transposée de l’aéronautique à la chimie, est au cœur d’une révolution silencieuse des procédés. Personne n’imaginerait aujourd’hui concevoir un avion uniquement avec des essais en vol ; la simulation est la norme. De la même manière, baser la sécurité d’un procédé chimique uniquement sur des essais pilotes en laboratoire est une approche dépassée, coûteuse et intrinsèquement risquée. Le modèle mathématique, ou jumeau numérique (Digital Twin), est devenu un outil de confiance pour prédire, contrôler et sécuriser les réactions.

Comme le rappellent les experts en sécurité des procédés, la modélisation offre une méthode précise et rigoureuse pour évaluer les risques. Plutôt que de multiplier les essais, le jumeau numérique permet de prendre des décisions plus éclairées et de concevoir des mesures de contrôle bien plus adaptées. C’est un changement de paradigme où l’on investit dans l’intelligence prédictive plutôt que dans la correction post-incident.

Les outils de modélisation de l’exposition offrent une méthode avancée et précise pour évaluer les risques chimiques. Ils permettent des décisions plus éclairées et des mesures de contrôle mieux adaptées, entraînant gains de coûts, de temps, de productivité et d’efficacité de production.

– A3P Association, Protection et modélisation de l’exposition aux agents chimiques

Un exemple frappant est le contrôle en temps réel des réactions de polymérisation. Traditionnellement, le suivi se fait par prélèvements manuels, une opération lente, parfois dangereuse et qui donne une information déjà obsolète. L’approche moderne couple une sonde de spectroscopie (comme la technologie Raman) directement dans le réacteur avec un modèle mathématique. Ce jumeau numérique traduit les données spectrales en concentration de monomère en temps réel. Cette approche élimine les prélèvements, fournit des résultats en quelques secondes et, surtout, permet d’explorer virtuellement les limites opératoires sans aucun risque physique, réduisant drastiquement le nombre d’expériences pilotes nécessaires.

Faire confiance à un modèle mathématique, c’est donc faire confiance à une représentation rigoureuse de la physique et de la chimie du procédé. C’est un outil qui ne remplace pas l’ingénieur, mais qui augmente sa capacité à comprendre et à maîtriser la complexité, transformant l’incertitude en risque calculé et contrôlé.

Le piège de la « vallée de la mort » entre le bécher et le pilote industriel

La « vallée de la mort » du scale-up est ce gouffre tristement célèbre où un procédé prometteur en laboratoire échoue lamentablement lors de son passage à l’échelle pilote ou industrielle. Les raisons sont multiples : des phénomènes physiques négligeables à l’échelle du bécher (exothermie, agitation, viscosité) deviennent dominants et incontrôlables dans un grand réacteur. Cet échec représente une perte de temps et d’argent considérable et peut tuer un projet d’innovation. Le traverser avec succès est une condition essentielle de la rentabilité de la R&D.

L’erreur fondamentale est de considérer le scale-up comme une simple multiplication des volumes. La solution réside dans une méthodologie intégrée dès les premières phases de la recherche : le Design for Manufacturing (DFM). Il ne s’agit plus de « passer le relai » de la R&D à la production, mais de faire collaborer les deux équipes dès le premier jour. Les contraintes de l’industrialisation (matériaux, limites de température/pression des équipements existants, normes de sécurité) doivent être intégrées comme des paramètres de conception au même titre que le rendement chimique.

Cela se traduit par des actions concrètes. Par exemple, au lieu de se contenter de mesurer le rendement final, le chimiste de R&D doit systématiquement documenter des paramètres physiques clés : l’évolution de la viscosité, la cinétique de la réaction, la quantité de chaleur dégagée. Ces données sont de l’or pour l’ingénieur procédés qui devra concevoir le réacteur industriel. L’implémentation d’un mini-pilote automatisé en laboratoire permet de collecter des milliers de points de données et de construire un modèle robuste bien avant d’investir dans un pilote coûteux.

Pour structurer cette démarche, l’adoption d’un plan d’action clair est la meilleure garantie de succès pour éviter que des projets innovants ne tombent dans ce piège classique.

Feuille de route pour franchir la « vallée de la mort » du scale-up

- Documenter systématiquement la viscosité, l’exothermie et la sensibilité à l’agitation dès les premiers essais en laboratoire.

- Créer des équipes « commando » mixtes R&D-Production responsables du scale-up de bout en bout.

- Implémenter un mini-pilote automatisé au laboratoire pour collecter des milliers de points de données de procédé.

- Établir des critères de transfert formels incluant des paramètres d’industrialisation (ex: temps de cycle max, type de filtration) dès la conception.

- Valider chaque étape du scale-up par simulation (jumeau numérique) avant de passer à l’échelle supérieure.

À retenir

- L’optimisation des coûts la plus durable vient de l’intensification des procédés (penser plus petit et plus contrôlé), pas de coupes budgétaires.

- Le Coût Total de Possession (TCO) doit systématiquement remplacer le coût d’achat (CAPEX) comme principal critère de décision pour les équipements.

- La simulation (CFD, jumeau numérique) n’est pas un coût mais un investissement à ROI rapide qui prévient les défaillances et optimise la qualité.

Comment transformer un laboratoire R&D en centre de profit pour l’entreprise ?

Traditionnellement, le département R&D est perçu comme un centre de coût, dont le succès se mesure en nombre de brevets ou de nouvelles molécules. Dans un contexte économique tendu, où les produits chimiques ont contribué à hauteur de +31% à l’inflation des importations en France, cette vision n’est plus tenable. L’avenir appartient aux entreprises qui savent aligner leur R&D sur des objectifs de rentabilité directs. La transformation la plus puissante consiste à faire évoluer le laboratoire de « centre de recherche » à « centre de services d’optimisation » pour l’ensemble du groupe.

La mission de ce « nouveau » laboratoire n’est plus seulement d’inventer, mais aussi d’améliorer. Ses équipes d’experts en chimie et en génie des procédés sont les mieux placées pour auditer les lignes de production existantes et y déceler des gisements de productivité. En appliquant les outils d’analyse fine du laboratoire (chromatographie, spectroscopie, calorimétrie) aux problèmes de production (baisse de rendement, lots non conformes, consommation excessive d’un réactif), la R&D peut proposer des solutions à fort impact financier.

Cette approche change radicalement la perception de la R&D. Une étude de PwC menée en 2023 montre que plus de deux tiers des dirigeants français cherchent activement à optimiser leurs coûts de production via leurs équipes internes. Le rapport souligne qu’en positionnant la R&D comme un pôle d’expertise au service de l’existant, il est possible de trouver 5 à 10% d’amélioration sur les procédés actuels, avec un ROI direct et facilement mesurable. Le laboratoire ne vend plus des promesses d’avenir, il livre des économies présentes.

Cette transformation nécessite un changement culturel : les objectifs des chercheurs doivent inclure des KPIs de production, et des budgets doivent être alloués à des projets d’optimisation de l’existant, et non uniquement à l’innovation de rupture. C’est en créant ce pont solide entre la recherche et la production que l’entreprise débloque une source de valeur inestimable et pérenne.

Pour initier cette démarche d’optimisation globale, l’étape suivante consiste à réaliser un audit de vos procédés critiques, non pas sous l’angle du coût de revient actuel, mais sous celui du potentiel d’intensification et du coût total de possession (TCO).